– Am hosting, am montat site-ul dar nu ştiu dacă trebuie să pun fişierul robots.txt, ce conţine şi la ce foloseşte?

Pentru că am constatat multe neclarităţi legate de fişierul robots.txt, vă voi expune astăzi câteva explicaţii şi recomandări privind utilizarea sa.

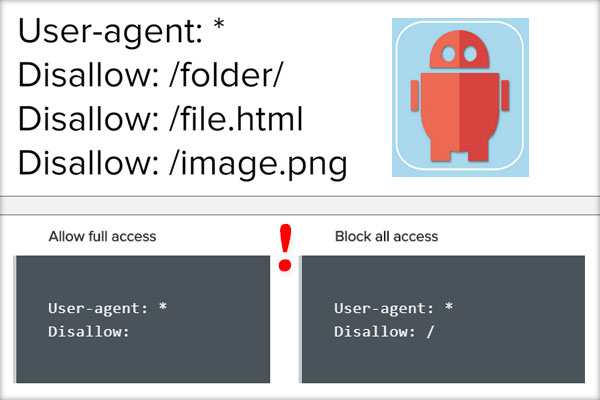

Despre Robots.txt

Fişierul robots.txt este un fişier adresat roboţilor de internet şi este uploadat numai de către webmaster cu scopul de a indica acestora anumite restricţii. Cea mai frecventă utilizare are în obiectiv spiderii motoarelor de căutare.

Disallow vs. Allow

Am vorbit de restricţii şi nu întâmplător nu vorbim de permisiuni. Fişierul robots.txt este o convenţie de prevenire a indexării de către roboţi a unor „zone” ale unui site, zone pe care webmasterul nu doreşte să le facă publice din orice motive.

Acest fişier mai este cunoscut ca Robots Exclusion Protocol sau ca Robots Exclusion Standard. Precum vedeţi nu se menţionează includerea (Allow) ci doar excluderea (Disallow).

Exemplu (Disallow)

User-agent: *

Disallow: /poze

Robots.txt winner = Disallow!

Se pare că în confruntarea teoretică dintre Disallow şi Allow, avem un câştigător net: robots.txt Disallow! Fiind un protocol de excludere, fişierul conţine specificaţii Disallow pentru fişiere şi directoare, iar restul site-ului este considerat implicit fără restricţii.

Din aceste considerente permisiunile „Allow” nu-şi au rostul, iar în cazul unui site cu acces complet permis, utilizarea acestui fisier nu este necesară.

Cum rămâne cu Allow?

Da, există şi directiva robots.txt Allow, însă nu vă recomand să o utilizaţi pentru că este non-standard şi poate fi interpretată diferit de anumiţi roboţi.

Dacă totuşi aveţi nevoie de ea, e bine să ştiţi că aceasta trebuie adăugată după blocare şi poate doar forţa accesul la unele fişiere, contrar unei alte directive Disallow ce blochează întregul director.

Exemplu (Allow)

User-agent: *

Disallow: /poze

Allow: /poze/poza.jpg

![WHD.ro [ Web Hosting & Design ]](https://www.whd.ro/WHD_header_logo.jpg)